Zwischen Innovation und Verantwortung

Mit der rasanten Entwicklung autonomer Robotersysteme, die zunehmend komplexe Entscheidungen treffen und mit Menschen interagieren, wächst die Notwendigkeit einer ethischen Reflexion dieser Technologie. Die Frage ist nicht mehr nur, was technisch möglich ist, sondern auch, was gesellschaftlich wünschenswert und ethisch vertretbar ist.

Robotik und künstliche Intelligenz verschmelzen zu Systemen, die menschenähnliche Fähigkeiten entwickeln – vom Erkennen von Emotionen bis hin zum selbstständigen Treffen komplexer Entscheidungen. Diese Entwicklung wirft fundamentale Fragen auf: Welche Grenzen sollten wir setzen? Wer trägt die Verantwortung für Entscheidungen autonomer Systeme? Und wie bewahren wir menschliche Würde und Autonomie in einer zunehmend von Maschinen geprägten Welt?

Zentrale ethische Herausforderungen der Robotik

Die Integration von Robotern in verschiedene Lebensbereiche wirft zahlreiche ethische Fragen auf:

- Autonomie und Entscheidungsfindung: Inwieweit dürfen Roboter selbstständig Entscheidungen treffen, besonders wenn diese Menschen betreffen?

- Verantwortung und Haftung: Wer ist verantwortlich, wenn ein autonomes System einen Schaden verursacht?

- Privatsphäre und Datenschutz: Wie gehen wir mit der massiven Datensammlung durch Robotersysteme um?

- Mensch-Maschine-Beziehung: Welche Grenzen sollten für emotionale und soziale Bindungen zwischen Menschen und Robotern gelten?

- Transparenz und Fairness: Wie stellen wir sicher, dass algorithmische Entscheidungen nachvollziehbar und frei von Diskriminierung sind?

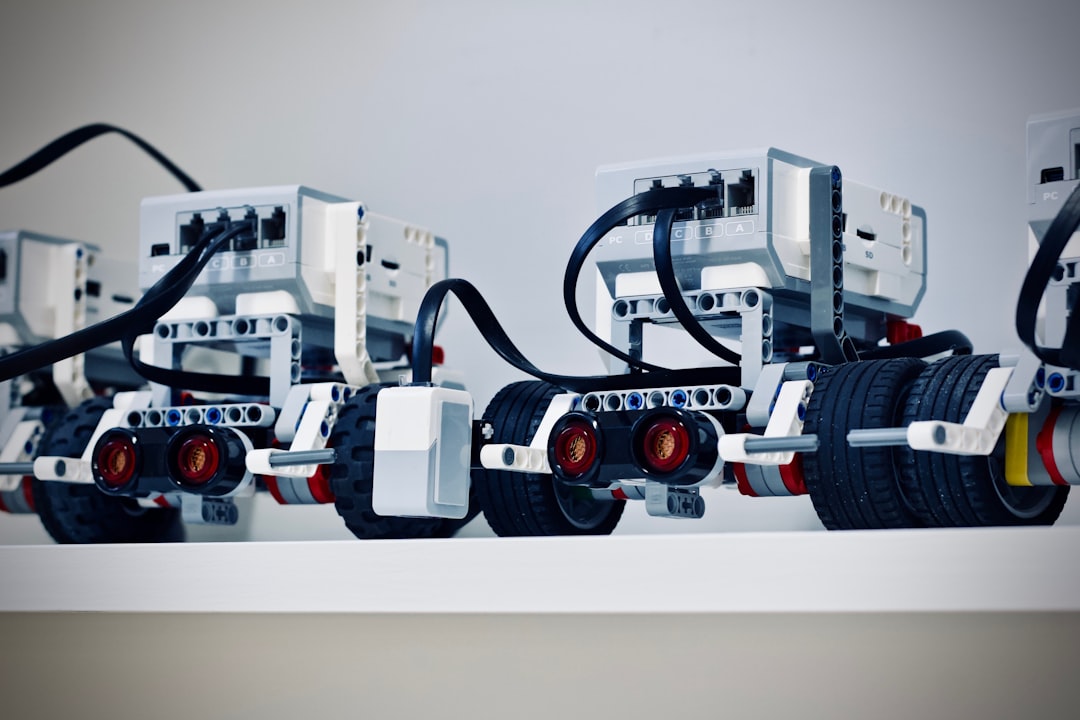

Die Beziehung zwischen Mensch und Roboter wirft grundlegende ethische Fragen auf

Ethische Grundprinzipien für die Robotik

Menschliche Kontrolle und Würde

Ein zentrales Prinzip ist, dass Roboter menschliche Entscheidungsfähigkeit ergänzen, aber nicht ersetzen sollten. Die Kontrolle über kritische Entscheidungen sollte letztlich beim Menschen verbleiben. Dieses Prinzip spiegelt sich in Konzepten wie "meaningful human control" wider, die besonders in Bereichen wie autonomen Waffensystemen oder automatisierten Entscheidungssystemen diskutiert werden.

Transparenz und Erklärbarkeit

Robotische Systeme sollten in ihrer Funktionsweise transparent und ihre Entscheidungen für Menschen nachvollziehbar sein. Dies ist besonders wichtig bei Systemen, die in sensiblen Bereichen wie Gesundheitsversorgung, Rechtsprechung oder Finanzwesen eingesetzt werden. Das Forschungsfeld der "Explainable AI" (XAI) widmet sich dieser Herausforderung, indem es Methoden entwickelt, die die "Black Box" komplexer Algorithmen öffnen.

Verantwortung und Rechenschaftspflicht

Auch wenn Roboter autonom agieren, müssen ihre Handlungen letztlich von Menschen verantwortet werden. Dies erfordert klare Verantwortungsketten und rechtliche Rahmenbedingungen. Die Frage der "distributed responsibility" zwischen Entwicklern, Herstellern, Betreibern und Nutzern ist ein aktives Forschungsfeld in der Roboterethik.

Gerechtigkeit und Nichtdiskriminierung

Robotische Systeme sollten fair und ohne Diskriminierung funktionieren. Dies erfordert besondere Aufmerksamkeit bei der Auswahl von Trainingsdaten und der Gestaltung von Algorithmen, um Vorurteile und Ungleichbehandlung zu vermeiden.

Schadensminimierung

Das Prinzip "primum non nocere" (vor allem nicht schaden) aus der Medizinethik gilt auch für die Robotik. Dies umfasst physische Sicherheit, aber auch psychologische und soziale Aspekte wie die Vermeidung von Abhängigkeit oder Manipulation.

"Die wahre Herausforderung der Roboterethik liegt nicht darin, Maschinen moralische Prinzipien beizubringen, sondern darin, unsere eigenen moralischen Prinzipien im Angesicht dieser neuen Technologien zu reflektieren und weiterzuentwickeln."

— Prof. Dr. Wendell Wallach, Yale University, Ethiker und Autor von "Moral Machines"

Anwendungsbereiche und spezifische Herausforderungen

Pflegeroboter und Soziale Robotik

Im Gesundheits- und Pflegebereich können Roboter wertvolle Unterstützung leisten, werfen aber auch Fragen nach menschlicher Würde und authentischen zwischenmenschlichen Beziehungen auf. Besonders kritisch ist die Frage, ob soziale Roboter, die Emotionen simulieren, eine Form der Täuschung darstellen oder ob sie legitime Hilfsmittel sind, die das Wohlbefinden verbessern können.

Autonome Fahrzeuge

Selbstfahrende Autos müssen in Sekundenbruchteilen moralische Entscheidungen treffen, etwa in unvermeidbaren Unfallsituationen. Die vieldiskutierten "Trolley-Probleme" der Ethik werden hier zu realen Designfragen für Algorithmen. Wer entscheidet, nach welchen Prinzipien diese Systeme handeln sollen, und wie transparent sollten diese Entscheidungsregeln sein?

Militärische Robotik

Autonome Waffensysteme, die ohne menschliches Eingreifen Ziele identifizieren und angreifen können, stellen eine der größten ethischen Herausforderungen dar. Die internationale Kampagne "Stop Killer Robots" fordert ein präventives Verbot solcher Systeme, während Befürworter argumentieren, sie könnten in manchen Kontexten sogar ethischer handeln als Menschen.

Arbeitsplatzrobotik

Die Automatisierung durch Roboter verändert die Arbeitswelt grundlegend. Hier stellen sich Fragen nach fairer Verteilung von Wohlstand, der Umschulung betroffener Arbeitnehmer und der sinnvollen Integration von Mensch und Maschine am Arbeitsplatz.

Ethische Rahmenbedingungen müssen bereits in der Entwicklungsphase von Robotersystemen berücksichtigt werden

Regulatorische Ansätze und Governance

Um ethische Prinzipien in der Praxis umzusetzen, werden verschiedene Governance-Ansätze diskutiert und erprobt:

Internationale Richtlinien und Standards

Organisationen wie die IEEE mit ihrer "Ethically Aligned Design"-Initiative oder die Europäische Kommission mit ihren "Ethics Guidelines for Trustworthy AI" entwickeln Rahmenwerke für ethische Robotik. Diese nicht-bindenden Richtlinien bieten Orientierung für Entwickler und Anwender.

Gesetzliche Regulierung

Die EU-Kommission hat mit dem "AI Act" einen der weltweit ersten umfassenden Regulierungsrahmen für KI und Robotik vorgeschlagen, der risikobezogene Kategorien und entsprechende Anforderungen definiert. Auch nationale Gesetzgeber arbeiten an spezifischen Regelungen für autonome Systeme.

Ethik-by-Design und Technikfolgenabschätzung

Der Ansatz "Ethics by Design" integriert ethische Überlegungen von Beginn an in den Entwicklungsprozess. Methoden wie "Value Sensitive Design" helfen, menschliche Werte systematisch in technische Systeme einzubauen. Parallele Technikfolgenabschätzungen begleiten den Entwicklungsprozess kontinuierlich.

Partizipative Gestaltung

Eine breitere Beteiligung verschiedener Stakeholder – von Entwicklern über Nutzer bis hin zu potenziell Betroffenen – kann dazu beitragen, dass robotische Systeme unterschiedliche Perspektiven und Werte berücksichtigen.

Die Verantwortung verschiedener Akteure

Die ethische Gestaltung der Robotik ist eine gesamtgesellschaftliche Aufgabe, bei der verschiedene Akteure spezifische Verantwortungen tragen:

- Forscher und Entwickler müssen ethische Überlegungen in ihre Arbeit integrieren und potenzielle Missbrauchsmöglichkeiten oder unbeabsichtigte Konsequenzen bedenken

- Unternehmen sollten über kurzfristige Gewinninteressen hinausdenken und Verantwortung für die gesellschaftlichen Auswirkungen ihrer Produkte übernehmen

- Politische Entscheidungsträger sind gefordert, angemessene regulatorische Rahmenbedingungen zu schaffen, die Innovation ermöglichen, aber auch Schutz bieten

- Bildungseinrichtungen müssen sowohl technische als auch ethische Kompetenzen vermitteln, um verantwortungsbewusste Entwickler auszubilden

- Die Zivilgesellschaft sollte sich aktiv an der Debatte beteiligen und kritische Perspektiven einbringen

Ausblick: Eine menschenzentrierte Robotik

Die Zukunft der Robotik wird nicht nur von technologischen Möglichkeiten bestimmt, sondern auch von den ethischen Rahmenbedingungen, die wir heute setzen. Eine menschenzentrierte Perspektive, die den Menschen mit seinen Bedürfnissen, Werten und Rechten in den Mittelpunkt stellt, ist dabei unverzichtbar.

Ethik in der Robotik sollte nicht als Bremse für Innovation verstanden werden, sondern als notwendige Orientierung, um Technologie zum Wohle aller zu gestalten. Die Integration ethischer Überlegungen kann die Akzeptanz und das Vertrauen in robotische Systeme fördern und damit langfristig zu ihrer erfolgreichen Etablierung beitragen.

Die Herausforderung besteht darin, einen kontinuierlichen gesellschaftlichen Dialog zu führen, der sowohl technologische Expertise als auch ethische Reflexion umfasst. Nur so können wir eine Zukunft gestalten, in der Roboter als Werkzeuge für menschliches Wohlergehen dienen und nicht zu einer Bedrohung für menschliche Würde und Autonomie werden.